在非UI线程上Show一个含有WebBrowser的Form出现的问题

问题描述 客户端的 Windows 程序使用 WebMethod 从服务器上取得一个系统信息列表。信息列表中有多条 Message。当系统消息的时间合要求,使用一个自定义的 MessageForm Show出这个系统 Message。MessageForm 是一个含有 WebBrowser 的 WinForm, Show MessageForm 的调用在一个 Timer 中被执行。当调用S...

问题描述 客户端的 Windows 程序使用 WebMethod 从服务器上取得一个系统信息列表。信息列表中有多条 Message。当系统消息的时间合要求,使用一个自定义的 MessageForm Show出这个系统 Message。MessageForm 是一个含有 WebBrowser 的 WinForm, Show MessageForm 的调用在一个 Timer 中被执行。当调用S...

Javascript中的错误处理有两种方法 使用 window.onerror 指定错误处理函数 当有错误的时候,onerror 会被 callback。 当某个JavaScript block中有多个script错误时,第一个错误触发后(回调callback),当前Javascript block后面的script会被自动Drop忽略掉,不被执行。 <html xmlns="ht...

用 Google 搜索关键字:西安二手车,发现这个网站的下面多了一段警告。提示:This site may harm your computer. 本网站可能危害您的电脑。点击link后google会弹出一个更大的警告让你不去访问这个网站。 看到这个提示,十分佩服 Google。把搜索和查毒集成在一起了。Google的搜索引擎真是牛。可是为什么 Google 会认为这个网站有问题会 har...

周末安康春游。 去的时候火车上的人还不多,回来的时候真恐怖,人好多。 赢湖的景色蛮不错。:) 可是没有时间去玩漂流。 :( GUIDE 看到青蛇,好恐怖。 比较奇怪的葡萄。

Generally define a JavaScript class using prototype chain. Because of JavaScript runtime executing and later binding, it’s hard to define a class like other oriental-object language C# or Java. In ...

今天天气真好。光线好,非常不错。 今天和很多好朋友出去春游,感觉不错。差点还喝多了 :) 。 看到这么舒服田园的住处。住在这里感觉一定挺爽吧。

以下的 static readonly 是否可以替换为 const? static readonly MyClass myins = new MyClass(); static readonly MyClass myins = null; static readonly A = B * 20; static readonly B = 10; static readonly...

今天的天气不是很好,阴沉沉的。没有什么太阳,和上次来相比差远了。今天的人真多,买票的队排了老长。还有几对人在拍婚纱照。气氛也不是很好,乱哄哄的…没有什么看樱花的感觉。

WebLinkSpider 网络爬虫。很多网站都会发现,经常有搜索引擎在访问自己的网站。搜索引擎访问网站是为了采集这个网站的信息,为搜索引擎提供内容服务。这种爬虫就是从页面中的一个链接跳到另一链接就这样一次又一次的跳,收集每个页面的信息,存储起来,为搜索引擎提供内容服务。 有了这些内容,当用户进行搜索的时候,搜索引擎从中找到相关的内容,把对应的Url和相关的内容返回给用。就完成了一个简单的...

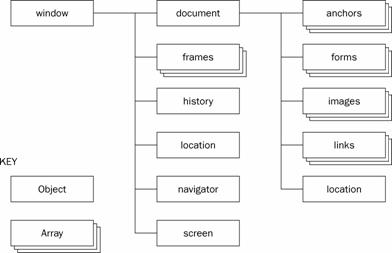

本文内容七拼八凑,内容来自不同地方。经过自己整理。 Dom 对象经常被讨论。还有一个很重要的对象Bom―Browser Object Module。 1.Top 和Parent 指向的内容是不同的。Top一定指向最外面的那个Window。而Parent指向当前frame的Parentframe。因为浏览器窗口自身被看作所有顶层框架的父框架。 2.self一个更加全局化的窗口指针,它总是...